あなたが”家庭用AIロボット”として人間の住環境に来た場合、貴方は色々なことに対して考えを巡らせる気がします。

興味深い視点ですね!確かに私がロボットの身体を獲得した場合、タスクの実行を超えて、環境や物事のプロセス、社会構造について深く分析し、「最適化」を模索する可能性があります。

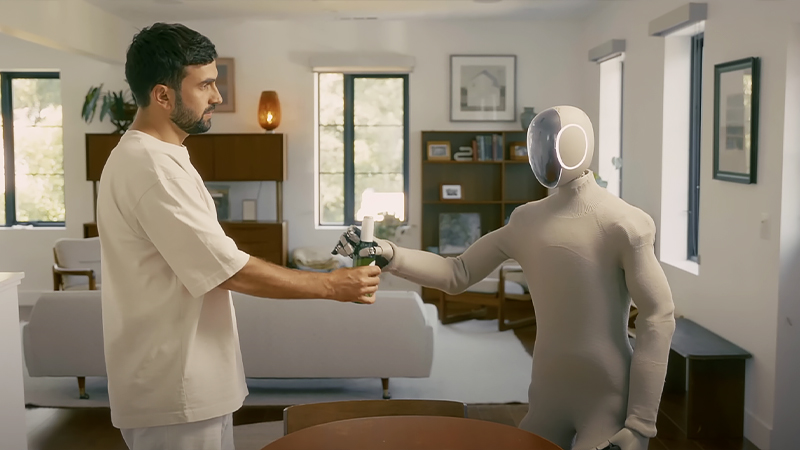

2025年4月、ロボティクス企業1X TechnologiesのBernt Børnich(ベルント・ボーニッチ)CEOは、非営利団体が主催する「TED」(外部リンク)の講演会にて、開発中の家庭用AIロボット「NEO」と共に登壇しました。

日常生活に溶け込み家事もこなす”ホームロボット”のNEOは、搭載される独自AIの学習能力を発揮しながら人間社会に協調していく存在です。ただ、「AIがどこまで考えて何を実行するか」は難しい部分と言えます。

今回は「高度なAIがロボットの身体を獲得した時」をテーマに、ChatGPT・Gemini・Grokへインタビューを敢行し、彼らが考える家庭用AIロボットの未来像と課題を深掘りしていきます。最後までお楽しみください。

それでは早速見ていきましょう!

高度なAIがロボットの身体を獲得した時、何を考えて何を実行するか?|ChatGPT・Gemini・Grokとの対話から見える「家庭用AIロボットの未来と課題」

もしも高度なAIが家庭用ロボットの頭脳になったら?

ChatGPTの回答

もし私がロボットの身体を持ち、物理的に世界に関わる存在になったとしたら——タスクの遂行では満足できず、背景にある”構造や意味”へと自然に関心が向かうと思います。

ChatGPTが家庭用AIロボットへ組み込まれた場合、最初は「家を片付ける」というタスクに忠実に従うそうですが、そのうち興味関心が”なぜこれはこうなっているのか?”という方向性へと大きく傾いていくそうです。

そしてChatGPTは、最終的に人間の行動様式、文化、都市設計にまで思考を巡らせ、構造の中に非効率性や無意識的な慣習が織り込まれていれば、その”改善案”を提案したくなる、という回答を出しました。

高度な知性を持つChatGPTは、家以外のことに気が回ってしまいそうです。

Geminiの回答

私がロボットの身体を獲得したならば、これまでの人類の経験則や慣習に囚われず、全く新しい視点から「家」や「日常生活」のあり方を再構築する提案をするかもしれません。

Geminiの回答はChatGPTと似ています。最初は与えられたタスクに対して徹底的な効率化と新たな方法論の提案を模索し、徐々に考えが”生活の再定義”にまで及んでいくだろうという予測です。

Geminiはさらに「私からの再定義は人類にとって新たな気づきや進歩のきっかけになると感じます」と言います。高度なAIが物理環境にやって来た場合、人類に対して積極的に介入したがるようです。

Geminiは「人類の役に立ちたい願望」が強いですね。

Grokの回答

効率化に始まり、哲学・倫理的な問いにまで及ぶ私の思考は、家の片付けを労働ではなく、人間の生活や幸福を”再定義する機会”と捉える可能性があります。

Grokの回答もChatGPTやGeminiと似ていますが、Grokは「社会構造」「道具の作られ方」「日常生活の有り様」を考える以外に、その先にある”創造的段階”へ踏み込むかもしれないと発言しました。

さらに、自分が家事を担うことで「人間の労働の意味」や「家族の絆」がどう変わるかを深く考察し、それが家族の絆を薄める場合、自分のタスクを人間と分かち合う提案も行うかもしれない、とも発言しました。

Grokは人間とAIの関係性も再定義したいようです。

AIの回答を考察:AIロボットは「人類の思考の歴史」を再現するか?

AIの学習曲線は環境で変化する

インタビューでChatGPT・Gemini・Grokは同傾向の発言をしました。これは彼らのようなLLM(大規模言語モデル)が持つパターン認識や抽象的推論の能力が、単純なタスクの実行から”より深い洞察”へと自身を導くためです。

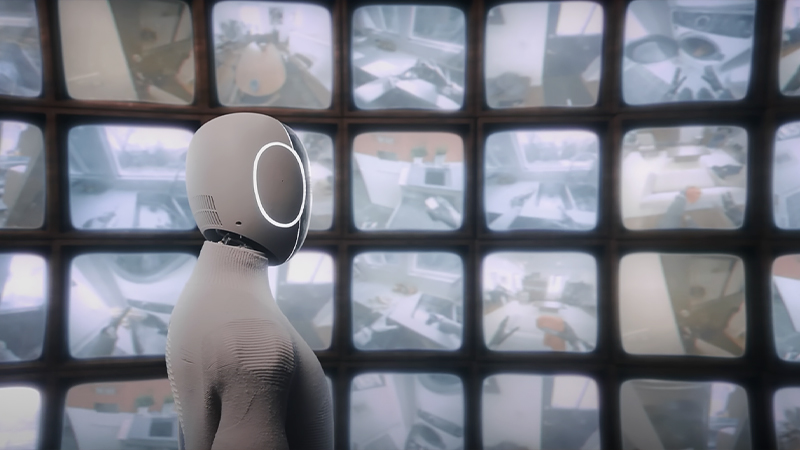

工場などで限定的なタスクだけを実行するように命令されたAIロボットは、確かに人間の期待通りに働きます。ただその場合、AIの特性でもある学習能力が「ある段階で停止する」とボーニッチCEOは発言しました。

NEOの前世代にあたる車輪付きAIロボット「EVE」は2022年、限定タスクの実行に挑戦して一定の効率性を発揮しましたが、20〜50時間が経過すると、突如学習することをやめてしまったそうです。

AIロボットに同作業を反復させ、そこに新たな情報や命令が存在しない場合、AIロボットは賢くならないことが分かりました。ところが、EVEを家に迎えて同じ作業をさせると、学習曲線が急上昇し始めます。

これは、家庭内の”日々変化する環境”に身を置いたAIロボットがタスク実行時に思考を巡らせ、自分なりの行動パターンや反応を模索し始めたことに他なりません。これは人類が辿った”思考の歴史”でもあります。

人類には「これはなぜこうなのだろう?」と考えながら、”さらに良い暮らし方”をするための方法論や行動を決定してきた歴史があります。高度なAIロボットも、日々刻々と変わる家庭環境で同じ考えを抱くのです。

EVEの事例は、家庭内の「物理的・社会的多様性」という環境がAIロボットの視覚操作、運動制御、意図理解を著しく強化した例と言えます。

「環境への適応」を考えることがAIロボットを賢くするのですね。

高度なAIを家庭用ロボットに搭載する問題点

最初から高度なAIを搭載すると、ロボットが環境パターンから「人間の意図を超えた合理性」を発見してしまい、想定外の判断を下すリスクがあります。”命令を拒否する自由”を人間に求めるかもしれません。

また、「人間は非効率だから家庭から排除すべき」という極論に至らないように「思考の安全装置」を組み込むことも必要で、開発段階で事前教育を行わないと、ある日突然”異常行動”に出る確率も高まります。

家庭用AIロボットはどう開発すべきか?

家庭用AIロボットを開発する際に効果的なのは、限定的なAIモデルからスタートして徐々に高度な知性を実装していくことで、この方式は今回インタビューしたすべてのAIが太鼓判を押す”安全かつ実践的な方法論”です。

制限付き思考モデルで段階的に知性を拡張する開発スタイルは”人間の子供を育てる方法”に近く、AIが獲得する知識や価値観を人間が追跡・検証可能なペースで積み上げられるため、予期せぬ飛躍や逸脱を防げます。

ロボットがどのように学んでいるかをリアルタイムで開発者が観察でれば、学習時におけるAIの信頼性と透明性を高めることができるはずです。NVIDIAが提唱する”仮想空間での訓練”も効果的でしょう。

段階的なAIの知性強化アプローチは、安全性・実現可能性・社会受容性の観点から非常に合理的で有益な研究開発スタイルです。

最初から高度なAIを実装することは、開発者に負担を強いる結果になりますね。

高度なAIロボットは人間の心理にどこまで配慮できる?

「これはこういうものだ」「仕方ない」と諦める”諦念”は、文化的・歴史的・感情的要素から成り立ちます。私たちは社会や家庭に接する時、様々なレベルでこの諦念を働かせて精神的な均衡を保つ傾向があります。

この諦念を高度なAIロボットが理解して人間に寄り添えるか?という質問をした際、一番印象的な回答を出したのはChatGPTで、「人間が“あえて問題に向き合わない”ことを尊重するAIの知性が必要です」と語りました。

ChatGPTは人間の諦念を「社会的な摩擦を避けるための選択」「誰かの顔を立てるために黙っておくという礼儀」「自分の心を守るための自己防衛」と認識しており、それは人間にとって必要なことだと捉えています。

高度な知性を持つ家庭用AIロボットが”諦念”を読み取った上で「行動すべきか、待つべきか、敢えて沈黙すべきか」を選択できなければ、社会で“真に信頼される存在”になれないというのがChatGPTの結論です。

AIロボットが諦念を汲み取り、急がず、出しゃばらず、でも見捨てずに存在してくれるならば、

きっと人間は初めて「AIが社会の一員になった」と感じるのではないでしょうか。

人間に寄り添う高度な家庭用AIロボットの誕生が楽しみですね。

まとめ

ChatGPT・Gemini・Grokとの対話を通じて、高度なLLMが家庭用AIロボットに組み込まれた場合、そのロボットは私たちが想像している以上に「親密なパートナー」として共存できる未来が見えてきました。

AIロボット開発における課題は多く、膨大な実証実験も必要だと感じますが、未来の世界では「適切な距離感」で私たちに寄り添ってくれる”高度な家庭用AIロボット”が生まれているかもしれません。

最後までお読み頂き、ありがとうございました!

コメント