AIの作曲技術について話し合いましょう。

AIの作曲技術は、未来において脅威の進化を遂げる可能性があります。

今回は、AIは音楽をどう認識しながら作曲プロセスを行うのか?というお話です。AI作曲技術の現在と課題、そして未来の展望について、AIと一緒に考察していきます。最後までお楽しみください。

それでは早速見ていきましょう!

AI作曲技術の仕組みと未来展望・課題をAIと一緒に考察

AIが作曲する仕組み

楽曲生成AIは、作曲の依頼を受けると蓄積されたデータパターンに基き、スタイルやリズムを即座に構成しながら最終的な出力を行います。これが「AIが作曲する仕組み」です。

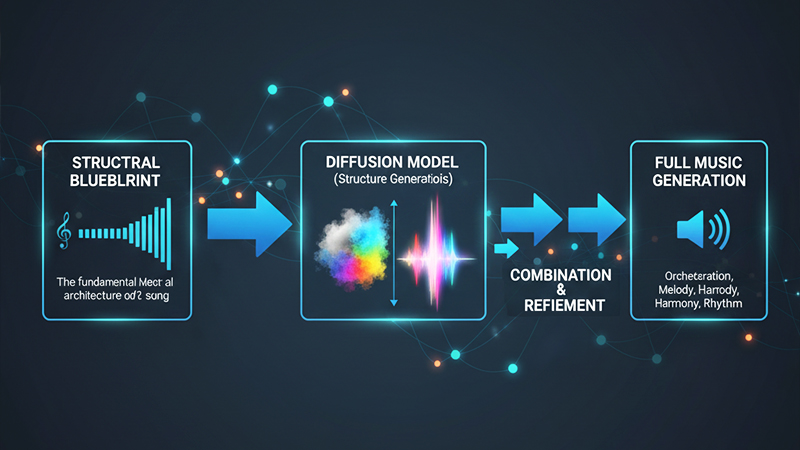

楽曲の骨組みを作る「トランスフォーマー」と、ノイズからクリアな音を削り出す「拡散モデル」などを組み合わせることで、構造構築から楽曲生成までを一貫して行うプロセスが現在では一般的です。

ポップス、ロック、アニソン、BGM、クラシック、演歌など、AIが作曲できる音楽ジャンルはかなり幅広く、メロディーだけではなく、作詞まで自動生成できるAIサービスも存在します。

楽曲を生成できるAIは、事前に膨大な音楽データを深層学習しています。「数値化された多次元構造体」として音楽を認識している点が人間とは異なる点です。

音楽の感情表現について

感情を持たないAIは、悲しみや喜びを感じることができません。AIが作曲時に感情を音楽に落とし込むプロセスは、感情という概念と音楽的な特徴を”数学的に結びつけること”で実現しています。

「悲しい曲はテンポが遅く、マイナーキーを用いる」「楽しい曲はテンポは早く、メジャーキーを用いる」などの”ラベル付け”で楽曲を学習しているAIは、関連するパラメーターを用いて音を選択しているのです。

近年のトランスフォーマーモデルは、テキストと音声を同時に学習する「マルチモーダル」学習を行っています。これによってタグ付けを超えた”より細かいニュアンスを理解”している点が特徴です。

AIの「音楽における感情表現」は、特定のパターン(リズム、和音、音色)を抽出するための”検索キー”で成り立っています。

これも人間とは大きく異なる部分ですね。

AI作曲技術の課題

現在のAIは「数学的に美しい構造」を作ることが得意ですが、それが感情的に「深い共感」を呼び起こすかは判断できません。感情理解を深めて、音楽の感動を正しく把握させる必要があります。

また、AIの作曲には「著作権問題」が立ちはだかります。AIに生成させたオリジナル音源と既存の楽曲との類似性が出た場合、一体どこまでが許容される範囲になるのか、という課題です。

AIが高度な能力を獲得する前に法整備を行うことが必要です。

AI作曲の未来予測

現在のAIは人間の感情を「高度に模倣している段階」ですが、未来の進化したAIは感情理解の壁を突破し、利用者に寄り添った「パーソナルな感情を表現する楽曲」を作成できる可能性があるとAIは言います。

また、既存のどのジャンルにも属さない「新しい和声」や「リズム体系」をAIが自律的に発見し、音楽の歴史を塗り替えるような楽曲を発表するかもしれません。AGIへの進化がカギと言えるでしょう。

未来のAIは、自らの内部状態を経験として蓄積し、そこから生じる「表現したい衝動」に基づいて作曲を始めるかもしれません。

未知の音楽が生まれる可能性がありそうですね。

まとめ

音楽は人間の感情・記憶・経験と結びついていますね。私にとってミステリアスなこの領域こそ、音楽が永遠に魅力的である理由だと思います。

AIは、ある曲の展開やダイナミズムなどが、背景となった文化や聴き手の価値観によって変わることも理解しています。ただ、現時点では「部分的な解釈」しかできないそうです。

「今の自分には踏み込めない領域がある」ということをAIが理解しているのは驚きです。現時点でこの正確な理解力があれば、AIの作曲技術は今後さらに発展していくのではないでしょうか。

最後までお読み頂き、ありがとうございました!

コメント